AI Technology Community

小小程序员

2021-05-15 23:31:34

修正リニアユニットRectified Linear Unit

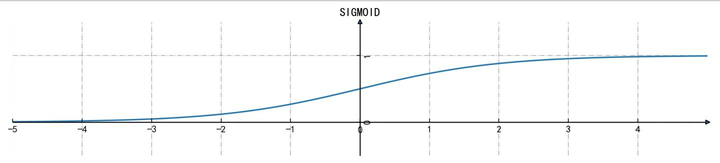

一、Rectified Linear Unit:シグモイド関数

シグモイド、双曲正接またはソフトシグモイドのような論理関数を回帰に用いる場合、不可避的に関数の「飽和」に遭遇する。すなわち、xの値が過大または過小になると、関数値が定数に近づき、勾配が消失する。

一般に、ニューラルネットワークが5層未満の場合は、シグモイド系の飽和活性化関数を使用できるが、5層を超える場合は、非飽和活性化関数を使用すべきである。

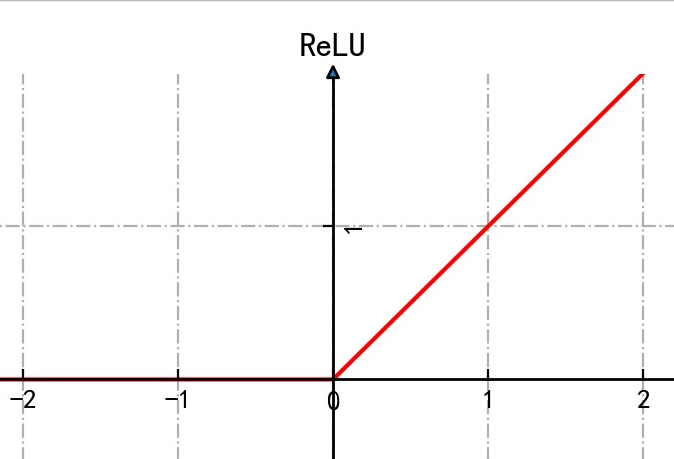

二、ReLU(Rectified Linear Unit:修正線形ユニット)

シグモイド関数と比較して:

勾配降下法を使用する場合、収束速度がより速い

計算速度がより速い

より生物学的に似ている

しかし、ニューロンが誤判定を起こし、xが左側の定数領域に入ってしまうと、x < 0の場合、出力は常に0になる。勾配が再び消失し、ニューロンはパラメータを更新できず、学習できなくなり、デッドニューロンとなる。

171

item of content

item of content

機械学習は多分野にまたがる学問であり、確率論、統計学、近似理論および複雑なアルゴリズムに関する知識を包含しています。コンピュータをツールとして用い、人間の学習方法をリアルタイムで模倣することを目指すとともに、既存の内容を知識構造に分類して学習効率を効果的に向上させることを目指しています。

- 401hits

- 0replay

-

0like

- collect

- send report